在开发者实验室中,阿里云为您提供了使用FastGPU进行一键部署并训练应用的相关实验教程,例如针对图像分类应用、bert-perseus应用以及手势识别应用的教程。该教程基于 Cloud Shell提供的真实环境,您可以通过在线Web IDE(Cloud Shell内置的代码编辑器)、命令行以及步骤式的教程指引,体验并完成所需教程的学习与实验。

FastGPU是一套构建在阿里云上的人工智能计算极速部署工具,其提供便捷的接口和自动化工具,实现人工智能训练或推理计算在阿里云IaaS资源上的快速部署。

Cloud Shell已预装了FastGPU工具,关于Cloud Shell的更多信息,请参见什么是云命令行。

FastGPU适用场景

适用场景 | 教程说明 | 难易程度 | 操作时长 |

图像分类应用场景 | 本教程介绍了通过阿里云FastGPU创建图像( | 基础级别 | 10~30分钟 |

bert-perseus应用场景 | 本教程介绍了通过阿里云FastGPU创建文本分类bert-perseusAI任务的全流程方案,您可以通过CLI自动创建并管理GPU实例。 | 入门级别 | 10~30分钟 |

手势识别应用场景 | 本教程介绍了通过阿里云FastGPU创建手势识别AI任务的全流程方案,您可以通过CLI自动创建和管理GPU实例。 | 入门级别 | <10分钟 |

操作步骤

本操作以使用FastGPU一键部署并训练手势识别应用场景为例,其他场景请参考以下操作。

前往开发者实验室。

在AIACC加速实战页签下,单击使用FastGPU一键部署并训练手势识别应用。

在对应训练教程面板下,单击开始实验。

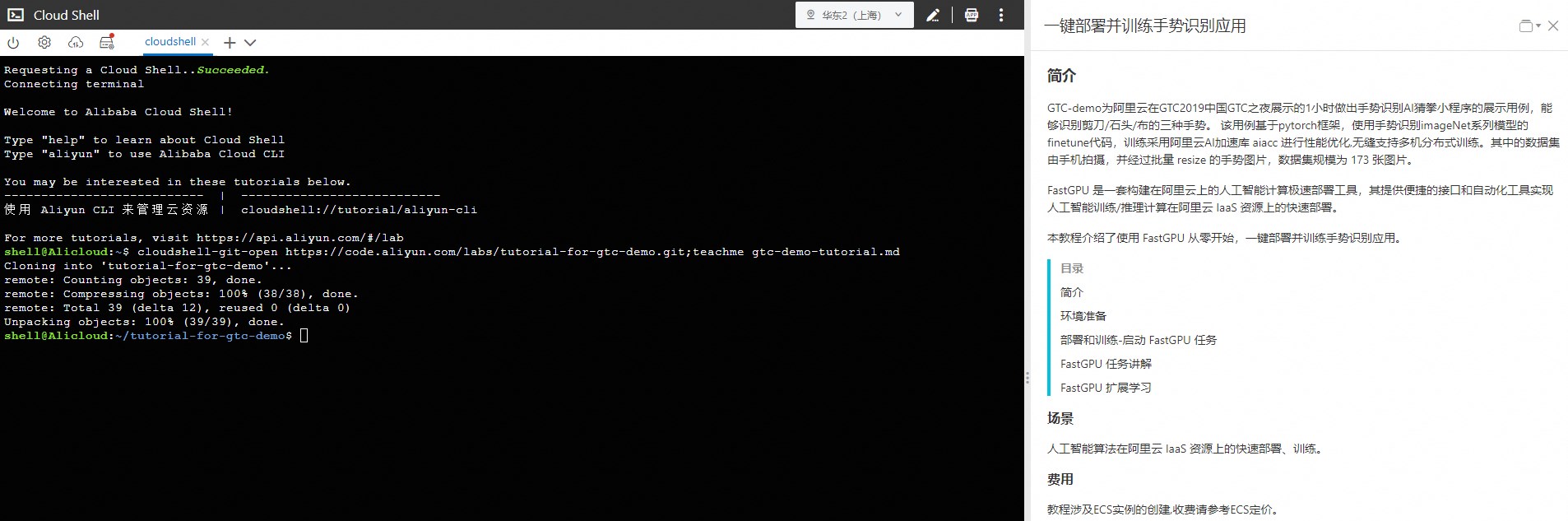

在弹出的git clone确认对话框,单击确认。

(条件必选)首次进入Cloud Shell时,会弹出挂载存储空间对话框,单击创建并绑定或暂不创建。

重要Cloud Shell支持关联并挂载一个NAS文件系统实例,该NAS可以帮助您持续化存储常用脚本和文件,否则您的文件会随GPU实例释放而销毁。如果后续需要挂载或解绑NAS,请参见持久化存储。

在Cloud Shell页面,根据教程指导体验使用FastGPU一键部署并训练应用的具体过程。