在Linux系统上使用GPU时,可能会因为GPU的GSP(GPU System Processor)组件运行状态异常,导致GPU卡在初始化时提示失败(例如出现XID 119或XID 120错误信息),本文为您介绍这种情况的解决方案。

问题现象

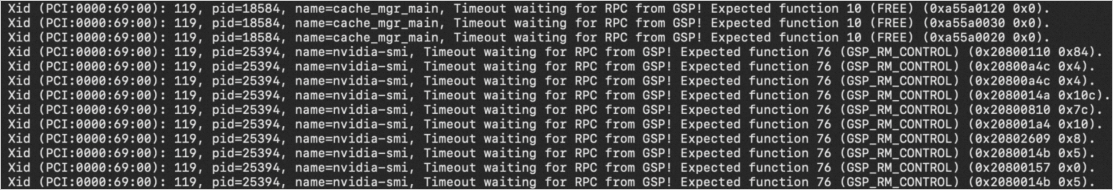

使用GPU时出现GPU掉卡现象,例如在Linux系统上使用GPU时,出现GPU卡初始化失败的错误提示。执行sh nvidia-bug-report.sh nvidia-bug-report.sh命令后,在生成的日志中,可以看到XID 119或XID 120错误信息。以XID 119报错页面为例,显示如下:

关于其他XID Errors的更多信息,请参见NVIDIA Common XID Errors。

问题原因

引起上述问题的原因可能是GPU的GSP(GPU System Processor)组件运行状态异常,升级NVIDIA最新版本驱动后,如果GPU掉卡问题仍然会复现,则建议您关闭GSP功能。

如果您想了解更多关于GSP功能的影响详情,请参见开启或关闭GSP功能的影响。

解决方案

远程连接GPU实例。

具体操作,请参见通过密码或密钥认证登录Linux实例。

执行以下命令,关闭GPU的GSP组件。

sudo su echo options nvidia NVreg_EnableGpuFirmware=0 > /etc/modprobe.d/nvidia-gsp.conf重启GPU实例。

具体操作,请参见重启实例。

再次登录GPU实例。

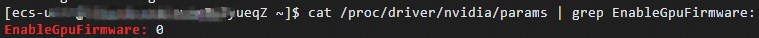

执行以下命令,查看

EnableGpuFirmware参数值。cat /proc/driver/nvidia/params | grep EnableGpuFirmware:如果返回结果是

EnableGpuFirmware: 0,则表示GPU的GSP组件关闭,问题已修复。 说明

说明只要

EnableGpuFirmware: 0,则执行nvidia-smi检查GPU卡状态时,其返回结果肯定是正常的。如果返回结果不是

EnableGpuFirmware: 0,则表示GSP组件没有关闭,请继续执行下一步确认NVIDIA GPU是否正常。

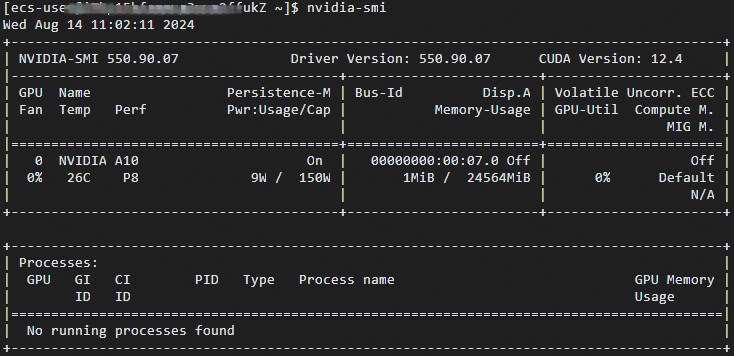

执行

nvidia-smi命令,确认NVIDIA GPU卡是否正常。如果返回结果显示GPU卡正常,例如GPU风扇转速、温度和性能模式等都正常,如下图所示,则问题已解决。

如果返回结果异常,表示NVIDIA GPU卡仍然存在问题,请联系阿里云运维技术人员进行关机迁移操作。